Apple anunció el martes una lista de funciones de accesibilidad que tienen como objetivo ayudar a los usuarios con discapacidades. Se dice que las nuevas funciones, que llegarán al iPhone, Apple Watch y Mac a finales de este año, utilizan hardware, software y avances de aprendizaje automático para ayudar a las personas con baja o baja visión o con discapacidades físicas o motoras. Las funciones incluyen Detección de puerta para usuarios de iPhone y iPad, Apple Watch Mirroring y subtítulos en tiempo real. Apple también anunció actualizaciones de VoiceOver, con 20 configuraciones regionales e idiomas adicionales.

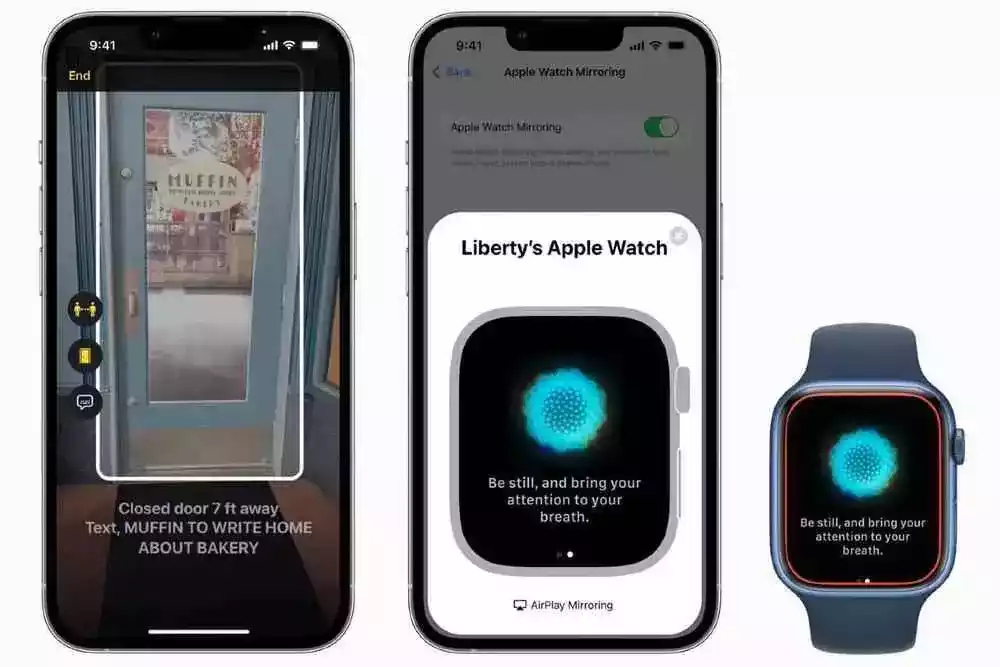

Una de las características de accesibilidad más útiles que Apple ha introducido como parte de su últimas actualizaciones es Detección de puerta que utiliza un sensor LiDAR en los últimos modelos de iPhone o iPad para ayudar a los usuarios a ubicar una puerta. La función utiliza una combinación de LiDAR, cámara y aprendizaje automático en el dispositivo para comprender qué tan lejos están los usuarios de la puerta y describir los atributos de la puerta, incluso si está abierta o cerrada, dijo la compañía.

Si la puerta está cerrada, la función de detección de puerta puede ayudar a las personas a abrirla empujando, girando una perilla o tirando de una manija. También se dice que lee señales y símbolos alrededor de la puerta, como el número de la habitación, e incluso reconoce la presencia de un símbolo de entrada accesible.

Detección de puertas, que funciona con iPhone 13 Pro, iPhone 13 Pro Max, iPhone 12 Pro, iPhone 12 Pro Max, iPad Pro de 11 pulgadas (2020), iPad Pro de 11 pulgadas (2021) y iPad Pro de 12,9 pulgadas (2020) y El iPad Pro (2021) de 12,9 pulgadas estará disponible a través de la aplicación Magnifier preinstalada.

La aplicación Magnifier de Apple tendrá un nuevo modo de detección para permitir el acceso a la función de detección de puertas. También tendrá detección de personas y descripciones de imágenes como las dos nuevas características que pueden funcionar solas o simultáneamente junto con la detección de puertas para ayudar a las personas con baja o baja visión.

Además de las actualizaciones dentro de Magnifier, Apple Maps también recibirá comentarios audibles y hápticos para los usuarios que tengan habilitado VoiceOver para ayudarlos a identificar el punto de partida para la dirección a pie, anunció la compañía.

El Apple Watch también recibirá soporte dedicado de Apple Watch Mirroring para permitir a los usuarios controlar el reloj inteligente de forma remota usando su iPhone emparejado. La nueva oferta ayudará a los usuarios a controlar el Apple Watch usando las funciones de asistencia del iPhone, incluido el control por voz y el control por botón. Los usuarios pueden usar entradas como comandos de voz, acciones de sonido, detección de cabeza e incluso interruptores externos Made for iPhone como alternativas para tocar la pantalla de Apple Watch.

Todo ello ayudará a las personas con discapacidad física y motora.

Apple dijo que Apple Watch Mirroring utiliza la integración de hardware y software en el sistema, incluidos los avances de AirPlay, para permitir a los usuarios usar funciones como el oxígeno en la sangre y el monitoreo de la frecuencia cardíaca y la aplicación Mindfulness. La función de duplicación funcionará con Apple Watch Series 6 y modelos posteriores.

Los usuarios de Apple Watch también obtendrán soporte para gestos de doble pellizco. Esto permitirá a los usuarios responder o finalizar una llamada telefónica, descartar una notificación, tomar una foto, reproducir o pausar medios en la aplicación Now Playing e iniciar, pausar o reanudar un entrenamiento, todo usando el doble gesto de pellizcar. Funcionará con AssistiveTouch en Apple Watch.

Para los usuarios sordos o con problemas de audición, Apple ha anunciado Live Captions en iPhone, iPad y Mac. Estará disponible a finales de este año en versión beta en inglés para usuarios de EE. UU. y Canadá en iPhone 11 y modelos posteriores, iPad con A12. Bionic y posterior y Mac con Apple silicon.

Los subtítulos en tiempo real funcionarán con cualquier contenido de audio, incluidas las llamadas telefónicas y FaceTime, así como las aplicaciones de videoconferencia o redes sociales, la transmisión de medios e incluso si los usuarios están teniendo una conversación con alguien a su lado, dijo la sociedad. .

![]()

Apple trae subtítulos en tiempo real a los usuarios de iPhone, iPad y Mac

Crédito de la foto: Apple

Los usuarios pueden ajustar el tamaño de fuente para facilitar la lectura. La característica en FaceTime también atribuirá el diálogo transcrito automáticamente a los participantes de la llamada para que sea más conveniente para los usuarios con discapacidad auditiva comunicarse entre sí a través de videollamadas.

En Mac, los subtítulos en tiempo real vendrán con la opción de escribir una respuesta y hacer que hable en voz alta en tiempo real a otras personas que forman parte de la conversación, dijo Apple. Indicó además que se generarán subtítulos en tiempo real en el dispositivo, teniendo en cuenta la privacidad y seguridad del usuario.

El lector de pantalla nativo de Apple, VoiceOver, también recibirá 20 idiomas e idiomas adicionales, incluidos bengalí, búlgaro, catalán, ucraniano y vietnamita. También habrá docenas de nuevas voces que se anunciarán para optimizar las funciones de asistencia en todos los idiomas admitidos.

Los nuevos idiomas, locales y voces también estarán disponibles para las funciones Leer selección y Leer pantalla. Además, VoiceOver en Mac funcionará junto con la nueva herramienta Text Checker para solucionar problemas de formato como espacios duplicados o letras mayúsculas fuera de lugar.

Apple también presentó algunas funciones de accesibilidad adicionales esta semana para celebrar el Día Mundial de Concientización sobre la Accesibilidad. Estas características incluyen Siri Pause Time, que ayudará a los usuarios a ajustar cuánto tiempo espera el asistente de voz antes de responder a una solicitud, Buddy Control para pedirle al médico o amigo que juegue, y reconocimiento de audio personalizable que se dice que está personalizado para reconocer sonidos que son específicos del entorno de una persona, como la alarma, el timbre o los electrodomésticos exclusivos de su hogar.

La aplicación precargada de Apple Books también incluirá nuevos temas y opciones de personalización, como texto en negrita y ajustes de espaciado de líneas, caracteres y palabras para brindar a los usuarios una experiencia de lectura más accesible. Además, la aplicación Accesos directos en Mac y Apple Watch a partir de esta semana ayudará a recomendar funciones de accesibilidad basadas en las preferencias del usuario mediante un nuevo acceso directo del Asistente de accesibilidad.

Apple Maps también recibirá una nueva guía de la National Park Foundation, Park Access for All, para ayudar a los usuarios a descubrir funciones, programas y servicios accesibles para explorar en la Guía de parques de EE. UU. de la Universidad de Gallaudet. También destacará empresas y organizaciones que valoran, aceptan y priorizan a la comunidad sorda y las lenguas de señas.

Los usuarios también recibirán aplicaciones e historias centradas en la accesibilidad de los desarrolladores en la App Store, así como la colección Transforming Our World en Apple Books con historias de y sobre personas con discapacidades. Apple Music también destacará las listas de reproducción de Saylists, donde cada una se centrará en un sonido diferente.

Asimismo, la aplicación Apple TV presentará las últimas películas y programas de gran éxito con una representación auténtica de las personas con discapacidades.

Los usuarios también tendrán la oportunidad de explorar colecciones seleccionadas por invitados de jugadores clave en la comunidad de accesibilidad, incluidos Marlee Matlin (“CODA”), Lauren Ridloff (“Eternals”), Selma Blair (“Introducing, Selma Blair”) y Ali Stroker. (“Navidad para siempre”), entre otros.

Esta semana, el servicio Apple Fitness + también traerá al entrenador Bakari Williams que utiliza funciones destacadas del lenguaje de señas americano (ASL), que incluyen indicaciones de audio, que son señales verbales breves y descriptivas para ayudar a los usuarios con baja o baja visión, y Time to Walk y Time to Reproduzca episodios que se convierten en “Tiempo para caminar o empujar” y “Tiempo para correr o empujar” para usuarios de sillas de ruedas.

ASL también será parte de cada entrenamiento y meditación de Apple Fitness +, y todos los videos incluirán subtítulos en seis idiomas. Los entrenadores también mostrarán cambios en cada entrenamiento para ayudar a las personas que necesitan asistencia de accesibilidad a participar.

Apple también está lanzando SignTime para conectar a los clientes de Apple Store y Apple Support con intérpretes de ASL a pedido. SignTime ya está disponible para los clientes en los Estados Unidos que usan ASL, en el Reino Unido que usan el lenguaje de señas británico (BSL) y en Francia que usan el lenguaje de señas francés (LSF). Además, las tiendas Apple Store de todo el mundo ya comenzaron a ofrecer sesiones en vivo durante la semana para ayudar a los clientes a descubrir funciones de accesibilidad en el iPhone, y los canales sociales de Apple Support muestran contenido práctico, dijo la compañía.

MiReal.me MiReal.me – Tu blog tecnológico con la más actualizada información

MiReal.me MiReal.me – Tu blog tecnológico con la más actualizada información