Lo que está en juego sigue aumentando en 2022 con respecto a la loca carrera de los megapíxeles. Después de que se lanzara al mercado el primer teléfono inteligente de 108MP a fines de 2019, este mes se superó el hito de 200MP con Motorola Edge 30 Ultra (revisión) y Xiaomi 12T Pro (práctico).

El iPhone 14 Pro mencionado anteriormente también cambió a una cámara de 48MP este año, lo cual es muy inusual para Apple. Sin embargo, la característica interesante de los sensores de ultra alta resolución no son las fotos de 100 MB utilizadas para las impresiones caseras, sino su zoom.

El iPhone 14 Pro (Max) tiene por primera vez una cámara de 48 MP de resolución. ¿Esto tiene sentido? / © NextPit

¿Cómo funciona el zoom 2x del iPhone 14 Pro?

A diferencia de las cámaras digitales completas, la gran mayoría de los teléfonos inteligentes no tienen lentes de zoom que puedan cambiar la distancia focal moviendo las lentes, debido a limitaciones de espacio. En cambio, hay sensores separados para diferentes niveles de zoom. El iPhone 14 Pro tiene un sensor para gran angular (0,5x), uno para gran angular (1x) y otro para teleobjetivo (3x).

Al hacer zoom con el gesto de dos dedos en la aplicación de la cámara, el teléfono inteligente ahora amplía digitalmente una imagen de la cámara a la siguiente ampliación del módulo de la cámara antes de cambiar. A medida que aumenta la ampliación digital, la calidad disminuye naturalmente. El grado de disminución depende de la cámara en cuestión.

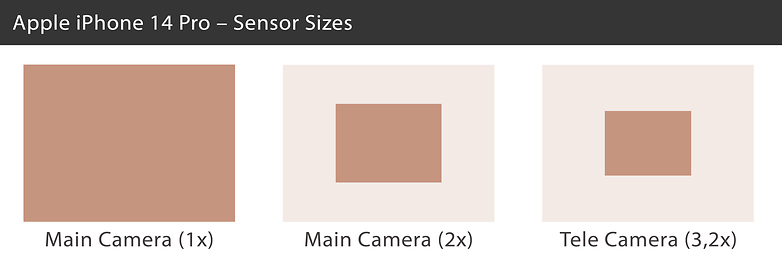

Vea una comparación del tamaño real del sensor en el iPhone 14 Pro. / © NextPit

La cámara principal del iPhone 14 Pro es un sensor de imagen de 1/1,28 pulgadas que mide 9,8 por 7,3 mm, con una resolución de 48MP. Con el zoom de 2x, Apple simplemente recorta una sección de 12 megapíxeles desde el centro del sensor, que aún mide 4,9 x 3,7 milímetros en el sensor y, por lo tanto, corresponde aproximadamente al formato de 1/3 de pulgada. Esto sigue siendo suficiente para fotos decentes en buenas condiciones de iluminación.

Con un zoom de 3x, Apple luego cambia al siguiente sensor de 12 megapíxeles (que en realidad es más como 3.2x con una distancia focal equivalente de 77 mm). Con el formato de 1/3,5 pulgadas o 4,0 por 3,0 mm, el sensor sigue siendo un poco más pequeño que el “sensor 2x” que se ha recortado en el centro de la cámara principal.

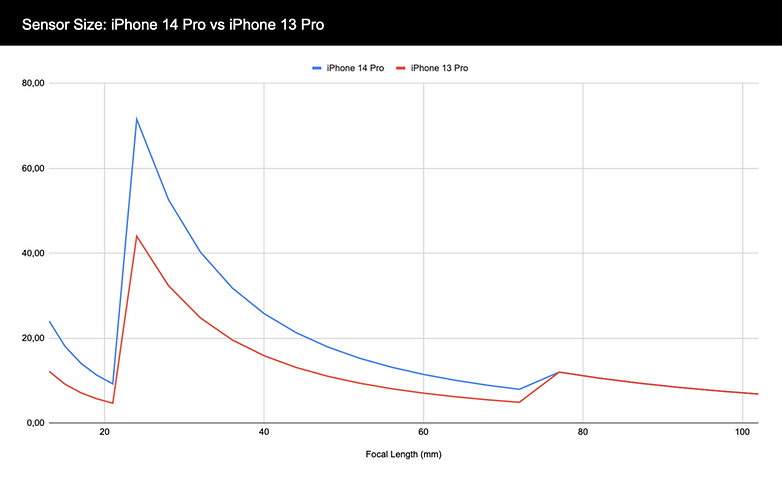

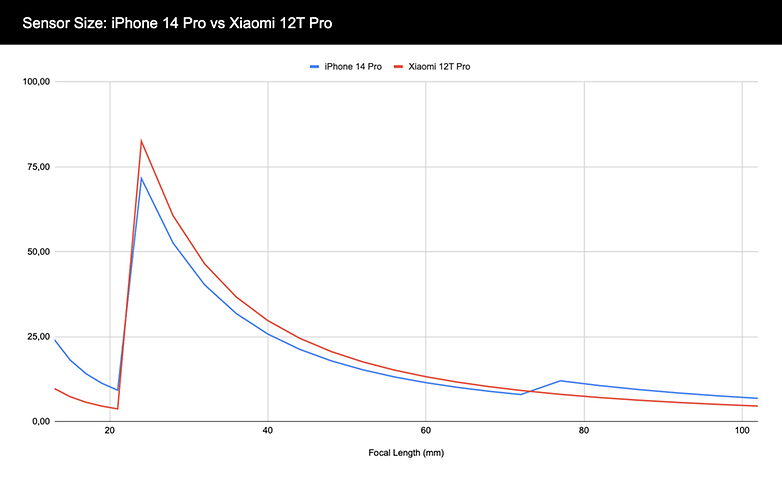

En la siguiente tabla, puede ver cuánta área de sensor está disponible para la cámara del iPhone 14 Pro y el iPhone 13 Pro en diferentes distancias focales. El ultra gran angular (13 mm) comienza en el extremo izquierdo del borde. La cámara principal (24 mm) muestra un aumento significativo. Hasta el teleobjetivo (77 mm), el iPhone 14 Pro siempre tiene más área de sensor disponible que el iPhone 13 Pro. Finalmente, la cámara de teleobjetivo sigue siendo idéntica.

Aquí puede ver cuánta área de sensor está disponible para la cámara del iPhone 14 Pro y iPhone 13 Pro con la distancia focal correspondiente. / © NextPit

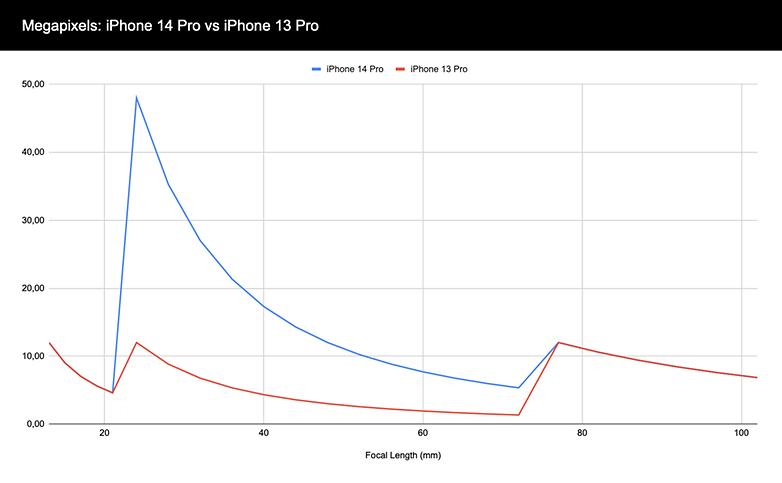

También es interesante el gráfico anterior, solo que con megapíxeles (MP) en lugar del área del sensor que se ve en el eje vertical. Si bien la progresión es idéntica para los sensores ultra gran angular y teleobjetivo de 12MP, el salto a 48MP es claramente perceptible. El iPhone 14 Pro tiene una resolución significativamente más alta para jugar con zoom digital que va de 1x a 3.2x.

El iPhone 14 Pro también tiene mucho más margen de maniobra en términos de resolución. / © NextPit

¿Qué tan grande y de alta resolución tiene que ser?

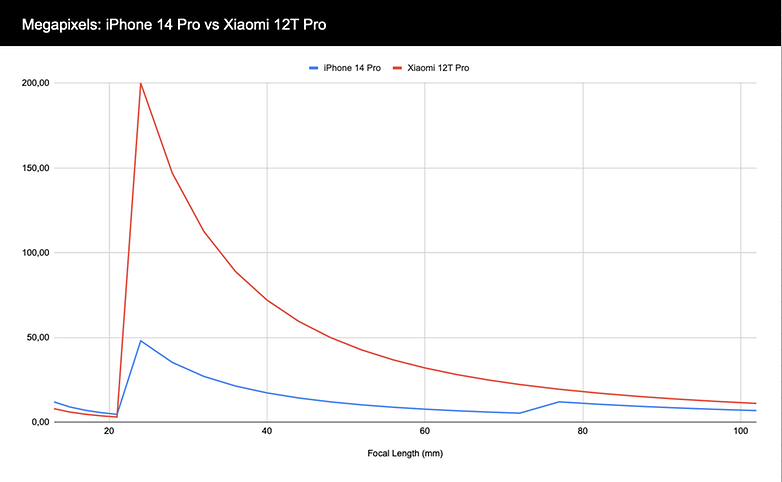

El iPhone 14 Pro discutido hasta ahora ni siquiera es el teléfono inteligente con la resolución más alta o el sensor más grande. Esta semana, Xiaomi lanzó el 12T Pro, que ofrece un sensor de 200MP y renuncia por completo a un teleobjetivo a cambio. Pero, ¿cuánto más espacio para el zoom digital ofrecen tantos megapíxeles? Echemos un vistazo a la comparativa con el iPhone 14 Pro:

El iPhone 14 Pro también tiene mucho más margen de maniobra en términos de resolución. / © NextPit

Sin embargo, el factor más importante además de la resolución es el área del sensor disponible para la cámara en diferentes distancias focales. La Isocell HP1 instalada en el Xiaomi 12T Pro es considerablemente más grande que la cámara principal del iPhone 14 Pro con 1/1,22 pulgadas, pero luego pierde en términos de área de sensor disponible cuando el teléfono inteligente de Apple cambia a zoom de teleobjetivo:

Xiaomi 12T Pro tiene más área de sensor disponible con la cámara principal. Sin embargo, el iPhone 14 Pro gana cuando se trata del sensor de teleobjetivo. / © NextPit

¿Y qué hay del quad-bayer?

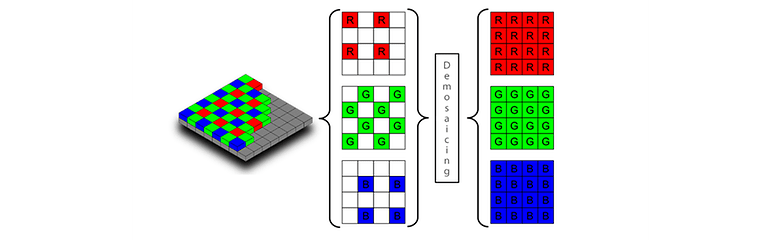

Hasta ahora hemos ignorado un factor: las máscaras de colores sobre el sensor. Para explicar Quad-Bayer, primero debemos ver cómo funcionan los sensores de imagen. Un sensor de imagen consta de muchos pequeños sensores de luz que solo miden la cantidad de luz incidente sin poder distinguir los colores. 12 MP significa tener 12 millones de sensores de luz.

Para convertir este sensor de blanco y negro en un sensor de color, un máscara de colores se coloca sobre el sensor para filtrar la luz incidente según verde, rojo o azul. La máscara de Bayer utilizada en la mayoría de los sensores de imagen siempre divide dos píxeles por dos en dos píxeles verdes, uno rojo y uno azul. Por lo tanto, un sensor con una resolución de 12 MP tiene seis millones de píxeles verdes y tres millones de píxeles azules y rojos cada uno.

Un sensor de Bayer (izquierda) tiene el doble de píxeles verdes que de píxeles rojos y azules. Durante la demostración, los vacíos resultantes se rellenan y los píxeles RGB se interpolan. / © Sony

En demosaico o de-bayering , los algoritmos de procesamiento de imágenes utilizan los valores de brillo de los píxeles circundantes de un color diferente para inferir el valor RGB de cada píxel. Un píxel verde muy brillante rodeado de píxeles azules y rojos “oscuros” se vuelve completamente verde. Y un píxel verde junto a los píxeles azules y rojos completamente expuestos se vuelve blanco. Y así sucesivamente, hasta que tengamos una imagen con 12 millones de píxeles RGB.

Sin embargo, con sensores de mayor resolución, la máscara de color se ve diferente. Con el llamado sensor quad-bayer, típicamente en el rango de 50 MP, hay cuatro píxeles de brillo debajo de cada píxel rojo, verde o azul. Los sensores de 108MP también agrupan nueve (3×3) píxeles bajo un área de color, y los sensores de 200MP tienen 16 (4×4) píxeles. Sony llama a esto quad-bayer, mientras que Samsung usa tetra, noveno o tetra2pixel.

El primer sensor con máscara de cuatro bahías fue el Sony IMX586, que se muestra aquí en la presentación del OnePlus 7. / © NextPit

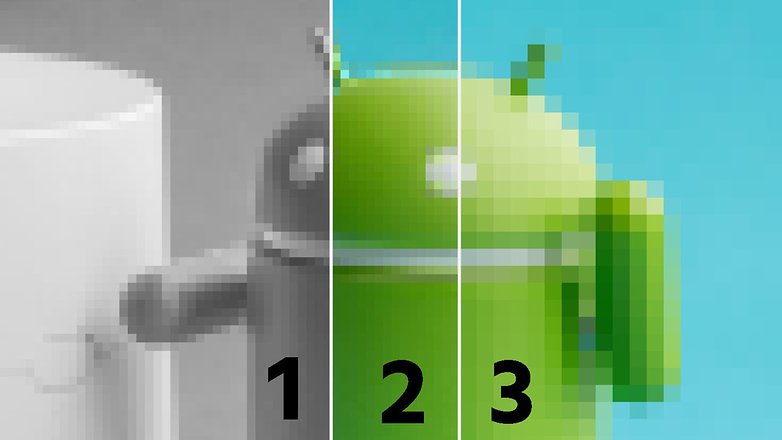

Mientras que los sensores de imagen en realidad tienen una resolución de hasta 200 MP en términos de brillo, la máscara de color se detiene en 12 MP. Esto tampoco es un problema, ya que en la percepción, la resolución del brillo es más importante que la resolución del color. Sin embargo, con zooms digitales extremadamente altos, la resolución del color finalmente disminuye hasta tal punto que se producen errores de imagen.

Por ejemplo, hemos procesado una foto de un pequeño androide aquí. A la izquierda (1) verá una imagen en escala de grises, a la derecha (3) una imagen RGB con un cuarto de resolución. La imagen central es una combinación de imágenes izquierda y derecha y, a primera vista, el resultado se ve muy bien. En una inspección más cercana, sin embargo, la transición entre el verde y el azul en la parte superior del androide es impura.

Y es precisamente en correspondencia con estas transiciones que se producen artefactos cuando se amplía demasiado un sensor en el que la máscara de color tiene una resolución inferior a la del propio sensor. Por cierto, Samsung probablemente usó un sensor de 64MP con una matriz RGB que no es típica para esta resolución para su muy difamado sensor de teleobjetivo 1.1x en el S20 Plus y S21 Plus por esa misma razón.

La resolución de brillo es más importante que la resolución de color: esta imagen centrada (2) se generó a partir de la imagen en blanco y negro de alta resolución (1) y la imagen en color de baja resolución (3). / © NextPit

La conclusión es que es difícil saber únicamente a partir de las especificaciones de hardware cómo se comporta la calidad de imagen en las cámaras, especialmente porque, en última instancia, también tienen un papel muy decisivo los algoritmos del fabricante. Y los llamados rimosaico también es un gran desafío para los sensores con bayermask 2×2, 3×3 o 4×4. A diferencia del demosaico normal, los valores de color deben interpolarse en áreas cada vez más grandes del sensor y con una complejidad cada vez mayor.

Por otro lado, los sensores cada vez más grandes también traen sus propios problemas. Para mantener las lentes compactas, los fabricantes deben usar lentes que refracten la luz cada vez más y, por lo tanto, tengan problemas con las aberraciones cromáticas y otros artefactos, especialmente en los bordes de la imagen. Y la poca profundidad de campo también es un problema a corta distancia.

Por lo tanto, sigue siendo emocionante y espero que haya encontrado interesante este viaje al mundo de los sensores de imagen extremadamente grandes y de ultra alta resolución. ¿Cómo se ve la cámara de tus sueños en un teléfono inteligente? ¡Espero tus comentarios!

MiReal.me MiReal.me – Tu blog tecnológico con la más actualizada información

MiReal.me MiReal.me – Tu blog tecnológico con la más actualizada información