publicado por Christiaan Prins, Product Manager, ML Kit y Shiyu Hu, Tech Lead Manager, ML Kit

Hace dos años en I / O 2018 presentamos ML Kit, haciéndolo más Es sencillo para los desarrolladores móviles integrar el aprendizaje automático en sus aplicaciones. Hoy en día, más de 25,000 aplicaciones en Android e iOS usan las características del Kit ML. Ahora estamos introduciendo algunos cambios que harán que el uso del Kit ML sea aún más fácil. Además, tenemos una nueva característica y una serie de mejoras que nos gustaría discutir.

Un nuevo kit de SDK para ML, completamente centrado en el ML del dispositivo

La API del kit de ML se ha creado para ayudarlo a enfrentar desafíos comunes en los dominios de Visión y Lenguaje Natural . Hacemos que sea fácil reconocer texto, escanear códigos de barras, rastrear y clasificar objetos en tiempo real, traducir texto y más.

La versión original de ML Kit estaba estrechamente integrada con Firebase y muchos de ustedes sintieron que querían más flexibilidad al implementarlo en sus aplicaciones. Como resultado, ahora estamos haciendo que todas las API estén disponibles en el dispositivo en un nuevo SDK ML Kit independiente que ya no requiere un proyecto Firebase. Si lo desea, puede usar ML Kit y Firebase para obtener lo mejor de ambos productos.

Con esta modificación, ML Kit ahora está completamente enfocado en el aprendizaje automático en el dispositivo, brindándole acceso a las ventajas únicas que ofrece el dispositivo en comparación con las ofertas de ML en la nube:

- Es rápido, desbloquea casos de uso en tiempo real dado que el procesamiento se lleva a cabo en el dispositivo, no hay latencia de red. Esto significa que podemos deducir en una secuencia de imagen / video o varias veces por segundo en cadenas de texto.

- Funciona sin conexión : puede confiar en nuestras API incluso cuando la red es impredecible o el usuario final de la aplicación está en un área sin conectividad.

- Se mantiene la privacidad : dado que todo el procesamiento se realiza localmente, no es necesario enviar datos confidenciales del usuario en la red a un servidor.

Por supuesto, todavía tiene acceso a los modelos de dispositivos de Google y las canalizaciones de procesamiento, todos accesibles a través de API fáciles de usar y ofrecidos de forma gratuita.

Todos los recursos del kit ML ahora están disponibles en nuestro nuevo sitio web, donde hemos facilitado mucho el acceso a las aplicaciones de muestra, los documentos de referencia API y los canales de nuestra comunidad que están allí para ayudarlo. si tienes preguntas.

¿Qué significa si ya uso ML Kit hoy?

Si está utilizando el Kit ML para API en su dispositivo Firebase hoy para su aplicación, le recomendamos que migre al nuevo SDK Kit ML independiente para beneficiarse de las nuevas funciones y actualizaciones. Para obtener más información e instrucciones detalladas para actualizar la aplicación, siga nuestra guía de migración. Las API basadas en la nube, la implementación de modelos y AutoML Vision Edge permanecen disponibles a través de Firebase Machine Learning.

Reduzca la huella de su aplicación con Google Play Services

Además de simplificar el uso de ML Kit, los desarrolladores también preguntaron si podemos enviar ML Kit a través de Google Play Services con la consiguiente reducción en el # 39; la huella de la aplicación y el modelo se puede reutilizar entre aplicaciones. Además del escaneo de códigos de barras y el reconocimiento de texto, ahora hemos agregado detección de rostros / contorno (tamaño del modelo: 20 MB) a la lista de API que admiten esta funcionalidad.

// Detección de rostro / Modelo de contorno de rostro // Proporcionado a través de Google Play Services fuera del APK de tu aplicación ... implementación "com.google.android.gms: play-services-mlkit-face-detect: 16.0.0" // ... o incluido con el APK de tu aplicación implementación "com.google.mlkit: detección de rostros: 16.0.0"

Compatibilidad con Jetpack Lifecycle / CameraX

Se ha agregado la compatibilidad con Android Jetpack Lifecycle a todas las API. Los desarrolladores pueden usar addObserver para administrar automáticamente el desmontaje de las API del kit ML mientras la aplicación pasa por la rotación de la pantalla o el cierre por parte del usuario / sistema. Esto simplifica la integración de CameraX. Con esta versión, también recomendamos a los desarrolladores que adopten CameraX en sus aplicaciones debido a la facilidad de integración y las mejoras en la calidad de imagen (en comparación con Camera1) en una amplia gama de dispositivos.

// El kit ML ahora es compatible con el ciclo de vida

val Recognizer = TextRecognizer.newInstance ()

lifecycle.addObserver (reconocedor)

// ...

// Al igual que CameraX

val camera = cameraProvider.bindToLifecycle (/ * lifecycleOwner = * / this,

cameraSelector, previewUseCase, analysisUseCase)

Para obtener una descripción general de todos los cambios recientes, consulte las notas de la versión del nuevo SDK.

Codelab del día – ML Kit x CameraX

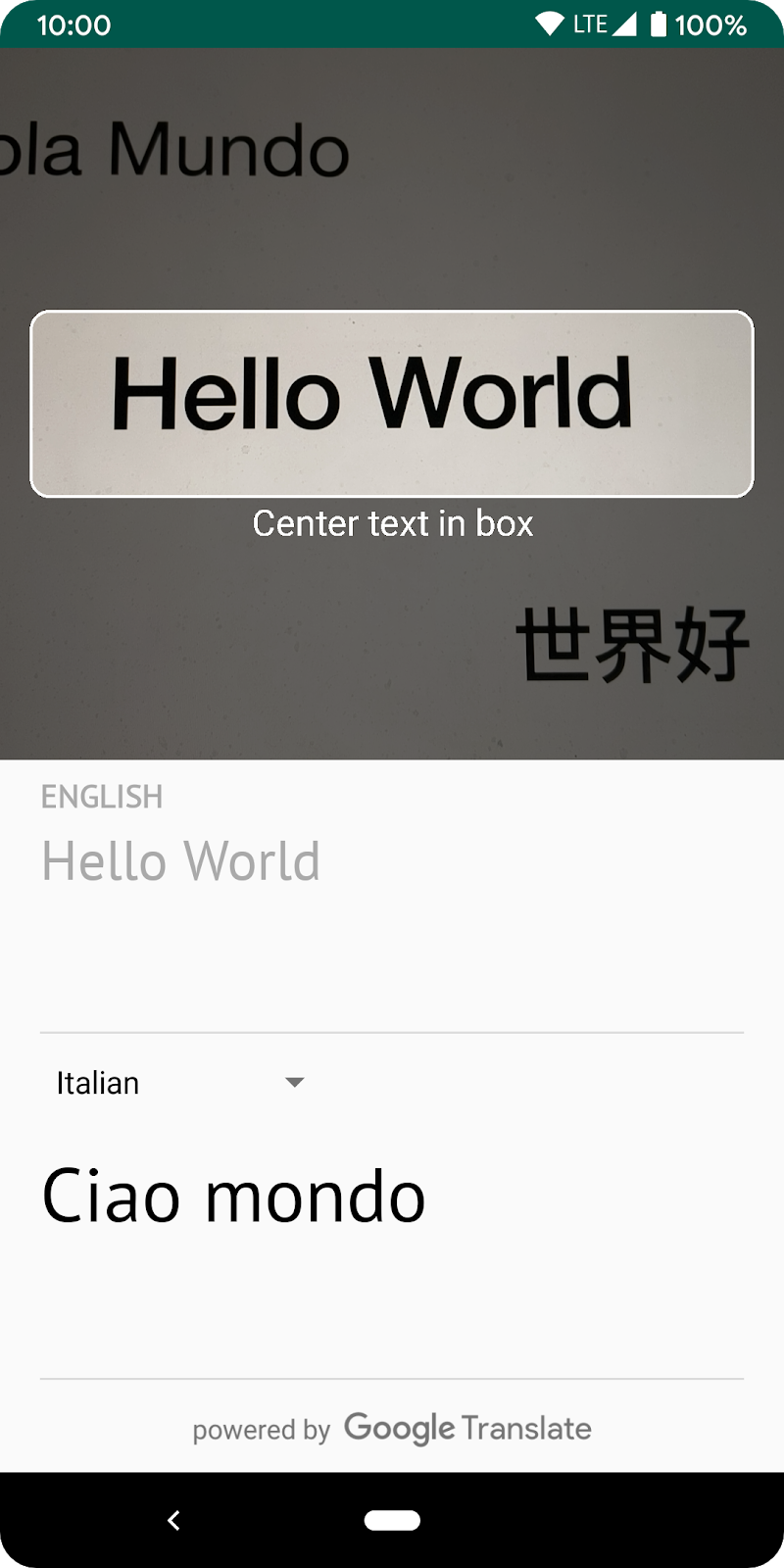

Para ayudarlo a comenzar con el nuevo ML Kit y su soporte para CameraX, creamos este laboratorio de códigos para reconocer, identificar el idioma y traducir el texto. Si tiene alguna pregunta sobre este laboratorio de códigos, créelos en StackOverflow y etiquételo con [google-mlkit]. Nuestro equipo supervisará esto.

Programa de acceso temprano

A través de nuestro Programa de acceso temprano, los desarrolladores tienen la oportunidad de colaborar con el equipo de ML Kit y tener la oportunidad. acceso a las próximas funciones. Dos nuevas API ahora están disponibles como parte de este programa:

- Extracción de entidad – Detecta entidades en el texto y hazlas utilizables. Tenemos soporte para números de teléfono, direcciones, números de pago, números de seguimiento, fecha / hora y más.

- Detección de pose – Detección de pose de baja latencia que admite 33 puntos esqueléticos, incluida la monitorización de manos y pies.

Si está interesado, visite nuestra página de inicio de sesión temprano para obtener más información.

Mañana – Soporte para modelos personalizados

Las soluciones llave en mano de ML Kit están diseñadas para ayudarlo a enfrentar desafíos comunes. Sin embargo, si era necesario tener una solución más personalizada, que requería modelos personalizados, generalmente era necesario crear una implementación desde cero. Para ayudar, ahora ofrecemos la opción de reemplazar las plantillas predeterminadas de Google con una plantilla personalizada de TensorFlow Lite. Comenzamos con la API Etiquetado de imágenes y Detección y seguimiento de objetos que ahora admite modelos de clasificación de imágenes personalizados.

Mañana, profundizaremos un poco más sobre cómo encontrar o entrenar un modelo TensorFlow Lite y usarlo con ML Kit o con la nueva función de enlace ML de Android Studio.

MiReal.me MiReal.me – Tu blog tecnológico con la más actualizada información

MiReal.me MiReal.me – Tu blog tecnológico con la más actualizada información