Contenido:

Dimensiones del sensor en pulgadas: desde tubos analógicos hasta chips CMOS

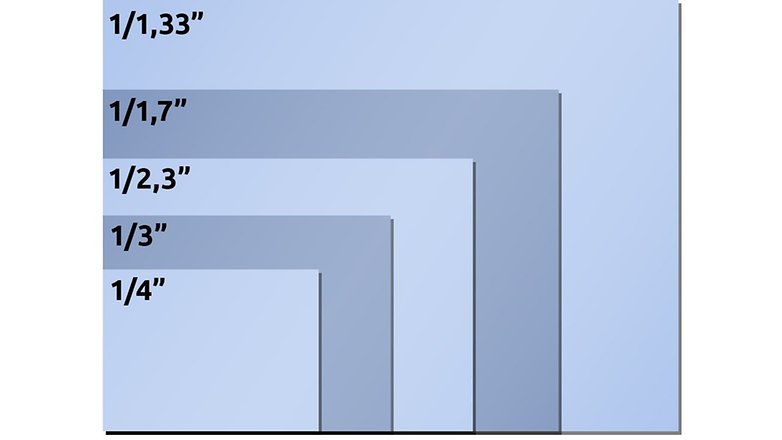

Comencemos con información básica: en la mayoría de las hojas de especificaciones de teléfonos inteligentes, el tamaño del sensor de la cámara tiende a ser de 1 / xyz pulgadas : por ejemplo, 1 / 1.72 pulgadas o 1/2 pulgada. Desafortunadamente, este tamaño no corresponde al tamaño real del sensor de su teléfono inteligente.

Y aquí está el quid de la cuestión: las personalizaciones se introdujeron hace aproximadamente medio siglo, cuando las cámaras de video todavía usaban tubos de vacío como convertidores de imágenes. Los departamentos de marketing aún mantienen el área aproximadamente sensible a la luz con gran vigor, aproximadamente el diámetro del tubo, casi hasta el punto de un aluvión imparable de correos electrónicos de extensión de pene enviados a mi carpeta de correo no deseado. Y ese es el nombre de un chip CMOS con una medición diagonal de 0.31 pulgadas por día en un sensor de 1/2 pulgada hoy.

Si desea conocer el tamaño real de un sensor de imagen, consulte la hoja de datos del fabricante o la página detallada de Wikipedia sobre el tamaño del sensor de imagen. O siga el ejemplo anterior y multiplique las dimensiones de los píxeles por la resolución horizontal o vertical.

Área efectiva del sensor: más grande es mejor

¿Por qué es tan importante el tamaño del sensor? Imagine la cantidad de luz que pasa a través de la lente en el sensor como si la lluvia cayera del cielo. Ahora tiene una décima de segundo para estimar la cantidad de agua que está cayendo actualmente.

- Con un vaso de chupito, esto será relativamente difícil para usted, pero en una décima de segundo, bajo una fuerte lluvia, tal vez caerán algunas gotas en el vaso, con poca lluvia o con un poco de mala suerte, tal vez ninguna . Su estimación será muy inexacta en ambos casos.

- Ahora imagine tener una piscina infantil para la misma actividad. Con esto, puede capturar fácilmente de unos cientos a unos miles de gotas de lluvia y, por cortesía de la superficie, puede hacer una estimación más precisa de la cantidad de lluvia.

Al igual que con el vaso de chupito, la piscina infantil y la lluvia, por ejemplo, lo mismo ocurre con el tamaño de los sensores y la cantidad de luz, ya sea mucho o poco. Cuanto más oscuro es, menos fotones son capturados por los convertidores de luz y menos preciso es el resultado de la medición. Estas inexactitudes luego se manifiestan en errores como ruido de imagen, colores rotos, etc.

De acuerdo: la diferencia en los sensores de imagen para teléfonos inteligentes no es tan grande como la que existe entre un vaso de tiro y una piscina para niños. Pero el Sony IMX586 mencionado anteriormente en el teleobjetivo Samsung Galaxy S20 Ultra es aproximadamente cuatro veces más grande en términos de tamaño de área que el sensor de 1 / 4.4 pulgadas en el teleobjetivo Xiaomi Mi Note 10.

Cuando se trata de hacer zoom: el hecho de que el fabricante escriba "100x" o "10x" en el exterior es de alguna manera equivalente al latido del pecho indicado por el velocímetro en un automóvil. Un VW Golf con un velocímetro que alcance 360 km / h no irá incluso más rápido que un Ferrari. Sin embargo, este es un tema que debería explorarse en otro artículo.

Bayer Mask & Co .: ahora se vuelve de color

Volvamos a la analogía del agua desde arriba. Si ahora colocamos una cuadrícula de 4.000 por 3.000 cubos en un césped, podríamos determinar la cantidad de lluvia con una resolución de 12 megapíxeles y probablemente tomar una especie de imagen de la saturación del agua de la nube de lluvia ambiental.

Sin embargo, si un sensor de imagen de 12 megapíxeles capturara la cantidad de luz con sus trampas de fotones de 4.000 por 3.000, la foto resultante sería en blanco y negro, porque solo medimos la cantidad absoluta de luz. No podemos distinguir ni los colores ni el tamaño de las gotas de lluvia que caen. ¿Cómo termina el blanco y negro como una foto en color?

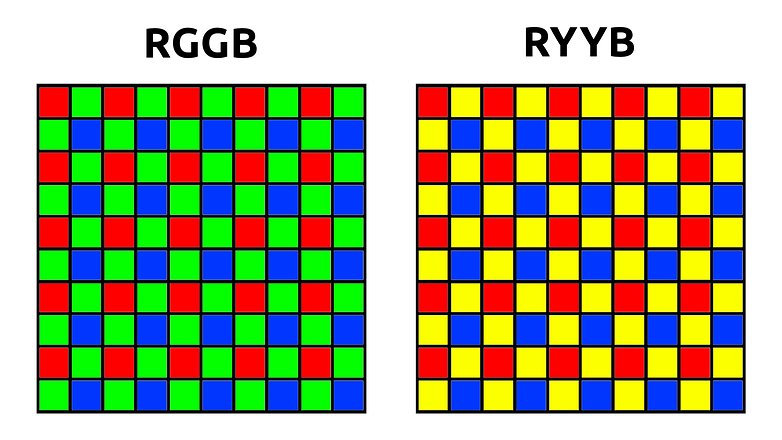

El truco consiste en colocar una máscara de color en el sensor, la llamada matriz de Bayer . Esto garantiza que solo la luz roja, azul o verde llegue a los píxeles. Con la matriz clásica de Bayer que tiene un diseño RGGB, un sensor de 12 megapíxeles tiene seis millones de píxeles verdes y tres millones de píxeles rojos y azules cada uno.

Para generar una imagen con doce millones de píxeles RGB a partir de estos datos, el procesamiento de imágenes generalmente usa píxeles verdes para la demostración. Usando los píxeles rojos y azules circundantes, el algoritmo luego calcula el valor RGB para estos píxeles, lo cual es una explicación muy simplificada. En la práctica, los algoritmos de demostración son mucho más inteligentes, por ejemplo, para evitar la franja de color en los bordes afilados, por lo tanto, el mismo principio sigue a los píxeles rojo y azul, donde una foto en color finalmente termina en la memoria interna de su teléfono inteligente.

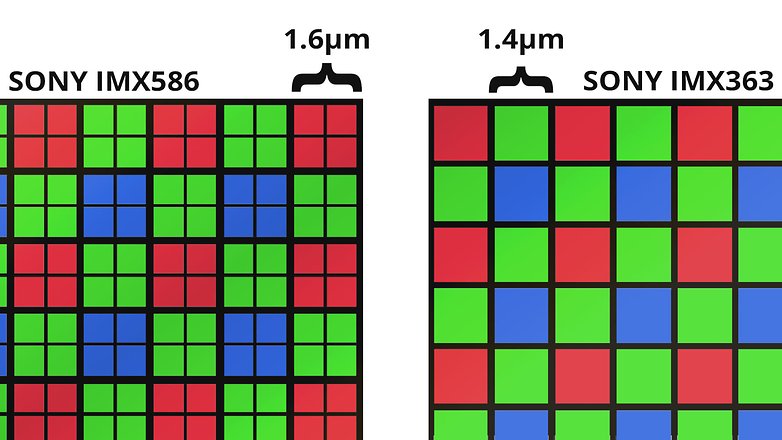

Quad Bayer y Tetracell

Ya sea que se trate de 48, 64 o 108 megapíxeles, la mayoría de los sensores actuales de ultra alta resolución en teléfonos inteligentes tienen una cosa en común. Si bien el sensor en sí tiene 108 millones de cubos de sensores de agua o luz, la máscara de Bayer que se encuentra arriba tiene un factor cuatro de resolución más baja. Por lo tanto, hay cuatro píxeles debajo de cada filtro de color.

Esto, por supuesto, se ve increíblemente hermoso cuando se especifica en la hoja de datos. ¡Un sensor de 48 megapíxeles! 108 megapíxeles! Son solo figuras en un globo de aire caliente para estimular la imaginación. Y cuando está oscuro, se pueden combinar pequeños píxeles para formar grandes superpíxeles mientras se obtienen hermosas fotos nocturnas.

Sin embargo, paradójicamente, muchos teléfonos inteligentes más baratos no ofrecen la opción de tomar fotos de 48 megapíxeles, o incluso proporcionan una calidad de imagen deficiente en comparación directa en el modo de 12 megapíxeles. En todos los casos que conozco, los teléfonos inteligentes son mucho más lentos cuando se toman fotos con una resolución máxima, ya que el ligero aumento en la calidad simplemente no vale la cantidad de tiempo dedicado, especialmente porque 12, 16 o 27 megapíxeles son completamente suficientes para todos. los días usan y no se quedan sin memoria del dispositivo tan rápido.

La mayor parte de la propaganda de marketing que empuja docenas de megapíxeles en el territorio de una tripa podría ser ignorada. Pero en la práctica, los sensores de alta resolución son en realidad más grandes, y la calidad de la imagen termina con ventajas significativas.

Sensor Huawei SuperSpectrum: el mismo en amarillo

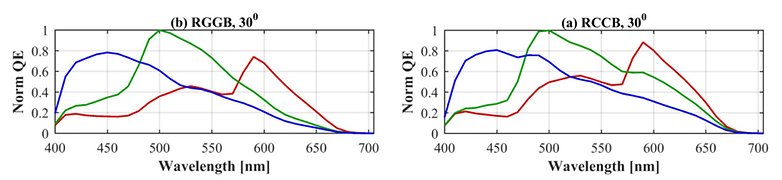

También hay algunos derivados de la matriz Bayer, el ejemplo más evidente es la llamada matriz Huawei RYYB (ver gráfico anterior), en la que el espectro la tasa de absorción se cambia a amarillo. Esto tiene, al menos en papel, la ventaja de que se absorbe más luz y llegan más fotones al sensor en la oscuridad.

Society for Imaging Science and Technology

Sin embargo, las longitudes de onda medidas por el sensor ya no se distribuyen uniformemente en todo el espectro y se separan claramente entre sí con respecto a un sensor RGGB. Para mantener niveles precisos de reproducción de color, las necesidades de los algoritmos, que posteriormente deben interpolar los valores de color RGB, tendrán que aumentar de manera correspondiente.

No es posible predecir qué enfoque producirá mejores fotos al final. Esto depende en gran medida de las pruebas prácticas y de laboratorio que tienden a demostrar "mejor" una u otra tecnología.

Software de la cámara: el algoritmo lo es todo

Finalmente, me gustaría decir algunas palabras sobre los algoritmos involucrados. Esto es aún más importante en la era de la fotografía computacional, donde el concepto de fotografía se vuelve borroso. ¿Una imagen compuesta por doce fotografías individuales sigue siendo una fotografía en el sentido original?

Lo que es seguro es esto: la influencia de los algoritmos de procesamiento de imágenes es mucho mayor que la cantidad de bits en un área del sensor. Sí, una diferencia de área de un factor de dos hace una gran diferencia. Pero un buen algoritmo también constituye mucho terreno. Sony, líder mundial en la industria de sensores, es un buen ejemplo. Aunque la mayoría de los sensores de imagen (al menos tecnológicamente) provienen de Japón, los teléfonos inteligentes Xperia siempre se han quedado atrás de la competencia en términos de calidad de imagen. Japón puede fabricar hardware, pero cuando se trata de software, el resto es más avanzado.

Samsung Galaxy S10. A la izquierda, se utilizó la cámara Google, mientras que a la derecha se representa la aplicación de la cámara Samsung. El modo HDR de Google es superior al de Samsung. No es sorprendente que muchos usuarios de teléfonos inteligentes prefieran la cámara de Google a sus teléfonos. / © AndroidPIT

En este punto, me gustaría tomar nota de la sensibilidad ISO, que también merece uno de sus artículos: por favor, nunca se impresionen con los números ISO. Los sensores de imagen tienen una única sensibilidad ISO nativa en casi todos los casos *, que rara vez aparece en las hojas de datos. Los valores ISO que establece la automatización del fotógrafo o la cámara durante el proceso de disparo real son más como ganancia: un grado de "control de brillo". Cuán "larga" es la escala de este control de brillo, se puede definir libremente, por lo que escribir un valor como ISO 409.600 en la hoja de datos tiene el mismo sentido que con un VW Golf … bueno, no nos aventuremos por ese camino.

* En realidad, hay algunos sensores ISO duales con dos sensibilidades nativas en el mercado de cámaras, como el Sony IMX689 en Oppo Find X2 Pro, al menos eso es lo que dice Oppo. De lo contrario, es más probable que este tema se encuentre en cámaras profesionales como la BMPCC 6K.

Enfoque automático: PDAF, 2×2 OCL & Co.

Una pequeña digresión al final, que está directamente relacionada con el sensor de imagen: todo el tema del enfoque automático. En el pasado, los teléfonos inteligentes han determinado el enfoque correcto a través del enfoque automático de contraste. Esta es una detección de bordes computacionalmente lenta e intensiva, que probablemente conozca por el molesto bombeo de enfoque.

La mayoría de los sensores de imagen ahora han integrado un denominado enfoque automático de comparación de fases, también conocido como PDAF. El PDAF tiene píxeles especiales de enfoque automático integrados en el sensor, que se dividen en dos mitades y comparan las fases de la luz incidente y calculan la distancia al sujeto. La desventaja de esta tecnología es que el sensor de imagen está "ciego" en estos lugares, y estos píxeles de enfoque ciego pueden afectar hasta el tres por ciento del área, dependiendo del sensor.

![AndroidPIT oppo encuentra la velocidad de enfoque x2 pro [19659053] ¡Amigo, es increíble! Oppo Find X2 Pro se enfoca increíblemente rápido en modo de video gracias a su sensor OCL 2x2. Un enfoque automático contrastante solo puede soñar con tal velocidad / © AndroidPIT

</figcaption></figure>

<p> Solo un recordatorio: un área de superficie más pequeña se traduce en una menor cantidad de luz / agua y, en consecuencia, una calidad de imagen más baja. Además, los algoritmos tienen que modificar estos defectos al igual que el cerebro tiene que entender el "punto ciego". </p>

<p> Sin embargo, existe un enfoque más elegante que no deja inutilizables los píxeles. Las microlentes que ya están presentes en el sensor se distribuyen en varios píxeles en algunos lugares. Sony, por ejemplo, llama a esto 2×2 OCL o 2×1 OCL, dependiendo de si las microlentes combinan cuatro o dos píxeles. </p>

<figure><img alt=](https://fscl01.fonpit.de/userfiles/7446224/image/wiki-image-sensor/sony-2x2-ocl-w782.jpg)

Pronto dedicaremos un artículo separado y más detallado al enfoque automático: ¿qué buscas en una cámara cuando compras un nuevo teléfono inteligente? ¿Y qué temas sobre fotografía móvil le gustaría leer más? ¡Espero tus comentarios!

Otros artículos sobre cámaras y fotografías para teléfonos inteligentes:

.

MiReal.me MiReal.me – Tu blog tecnológico con la más actualizada información

MiReal.me MiReal.me – Tu blog tecnológico con la más actualizada información