Apple anunció una gama de funciones de accesibilidad diseñadas para personas con limitaciones cognitivas, auditivas, visuales y de movilidad. Estas funciones estarán disponibles a través de actualizaciones de software a finales de este año. Una de las características más interesantes es el Apple Watch, que permite a las personas con diferencias en las extremidades navegar por su interfaz utilizando AssistiveTouch. Los usuarios de iPhones y iPads también serán parte del nuevo tratamiento centrado en la accesibilidad. Además, Apple anunció un nuevo servicio de intérprete de lenguaje de señas llamado SignTime que estará disponible para comunicarse con AppleCare y el soporte al cliente minorista.

AssistiveTouch en watchOS permitirá a los usuarios de Apple Watch navegar por un cursor en la pantalla a través de una serie de gestos con las manos, como pellizcar o apretar. manzana Él dice El Apple Watch utilizará sensores de movimiento integrados, como el giroscopio y el acelerómetro, junto con el sensor óptico de frecuencia cardíaca y el aprendizaje automático en el dispositivo, para detectar diferencias sutiles en el movimiento muscular y la actividad de los tendones.

El nuevo soporte para el control por gestos a través de AssistiveTouch permitiría a las personas con diferencias en las extremidades responder más fácilmente las llamadas entrantes, controlar un puntero de movimiento en la pantalla y acceder al Centro de notificaciones y al Centro de control, todo en un Apple Watch, sin necesidad de tocar la pantalla. o mueva la Corona digital. Sin embargo, la compañía no ha proporcionado detalles sobre qué modelos de Apple Watch serán compatibles con las nuevas funciones.

Además de los controles de gestos en el Apple Watch, iPadOS admitirá dispositivos de seguimiento ocular de terceros para permitir a los usuarios controlar un iPad usando sus ojos. Apple dice que los dispositivos MFi (Made for iPad) compatibles rastrean dónde está mirando una persona en la pantalla para mover el puntero en consecuencia para seguir la mirada de la persona. Funcionará para realizar varias acciones en el iPad, incluido un toque, sin que los usuarios tengan que tocar la pantalla.

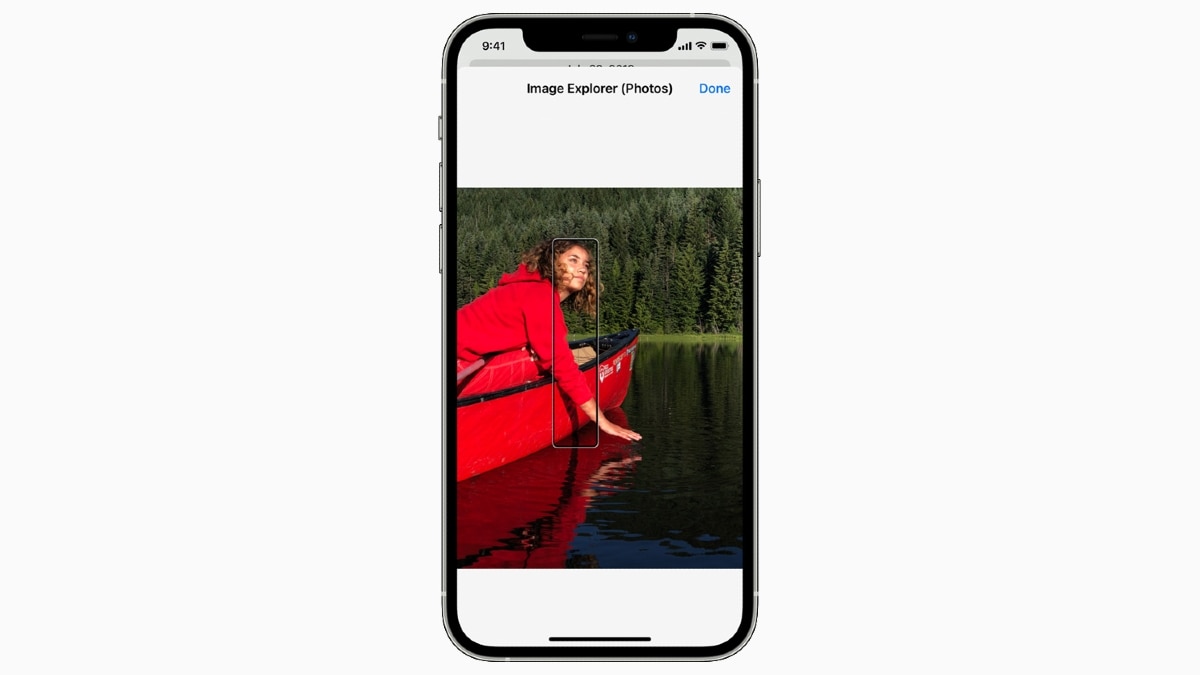

Apple también está actualizando su lector de pantalla precargado, VoiceOver, con la capacidad de permitir que las personas exploren más detalles en las imágenes. Estos detalles incluirán texto, datos de tablas y otros objetos. Las personas también podrán agregar sus propias descripciones a las imágenes con Markup para crear una atmósfera personalizada.

Apple está actualizando VoiceOver con más capacidad de detalle en las imágenes

Crédito de la foto: Apple

Para las personas neurodiversas o cualquiera que se distraiga con los sonidos cotidianos, Apple ofrece sonidos de fondo como ruidos equilibrados, claros y oscuros, así como sonidos del océano, la lluvia y el flujo que seguirán sonando de fondo para enmascarar el entorno o el sonido externo. Estos “ayudarán a los usuarios a concentrarse, mantener la calma o descansar”, dijo Apple.

Apple también está trayendo sonidos de boca como un clic, pop o sonido “ee” para reemplazar botones físicos e interruptores para usuarios que no hablan y tienen movilidad limitada. Los usuarios también podrán personalizar la configuración del tamaño de la pantalla y el texto para cada aplicación de forma individual. Además, habrá nuevas personalizaciones de memoji para representar a los usuarios con tubos de oxígeno, implantes cocleares y un casco blando para el arnés.

Las personalizaciones de los memoji de Apple tendrán implantes cocleares, tubos de oxígeno y un casco blando para el arnés.

Crédito de la foto: Apple

Además de los cambios importantes en el software, Apple está agregando soporte para nuevos audífonos bidireccionales a su programa de audífonos MFi (Made for iPhone). Los modelos de próxima generación de los socios de MFi estarán disponibles a finales de este año, dijo la compañía.

Apple también está introduciendo soporte para reconocer audiogramas (gráficos que muestran los resultados de una prueba de audición) en las soluciones de auriculares. Permitirá a los usuarios cargar los resultados de sus pruebas de audición en Adaptaciones de auriculares para amplificar más fácilmente los sonidos suaves y ajustar ciertas frecuencias en función de sus capacidades auditivas.

A los usuarios no se les han dado plazos concretos sobre cuándo pueden esperar que las nuevas funciones lleguen a sus dispositivos Apple. Sin embargo, es seguro esperar que se anuncien algunos detalles en la Conferencia Mundial de Desarrolladores de Apple (WWDC) el próximo mes.

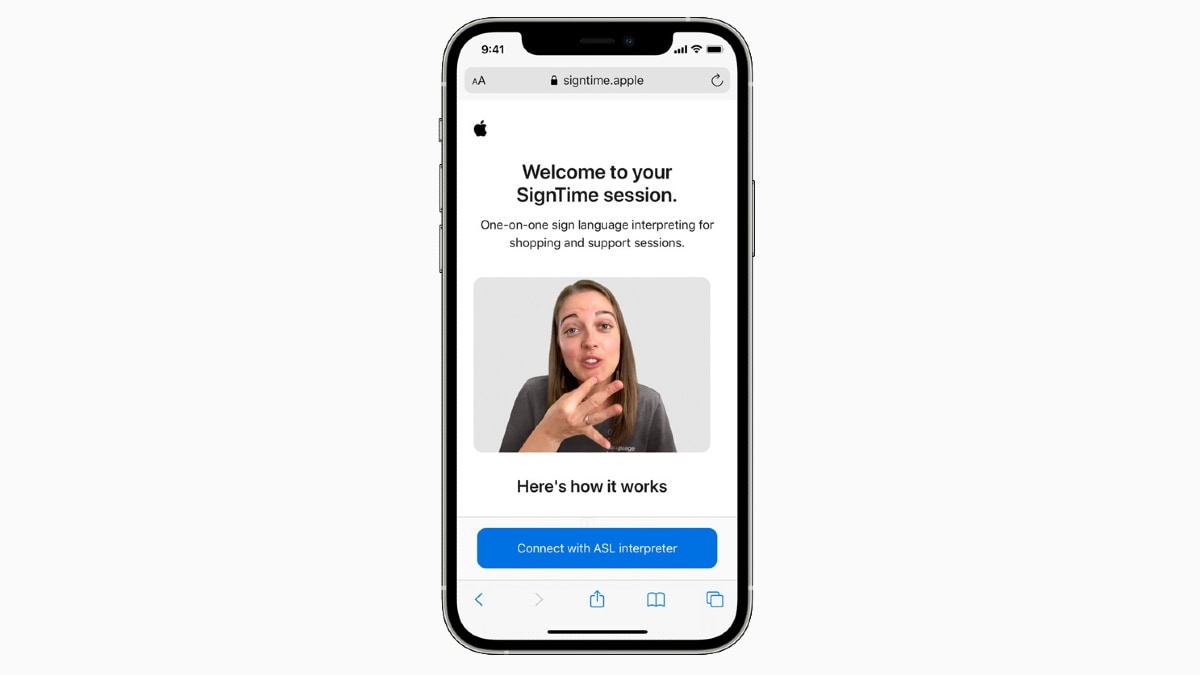

Apple también lanzará el servicio SignTime para comunicarse con AppleCare y el soporte al cliente minorista utilizando el lenguaje de señas americano (ASL) en los Estados Unidos, el lenguaje de señas británico (BSL) en el Reino Unido y el lenguaje de señas francés (LSF) en Francia directamente desde un navegador web. También estará disponible en las Apple Stores físicas para acceder de forma remota a un intérprete de lenguaje de señas, sin necesidad de reserva previa.

Apple presenta el servicio de intérprete de lenguaje de señas SignTime para facilitar la comunicación con el personal de servicio

Crédito de la foto: Apple

El servicio SignTime estará disponible inicialmente en EE. UU., Reino Unido y Francia a partir del 20 de mayo. Apple planea expandir el servicio a otros países en el futuro, aunque los detalles en este frente pueden revelarse en una etapa posterior.

.

MiReal.me MiReal.me – Tu blog tecnológico con la más actualizada información

MiReal.me MiReal.me – Tu blog tecnológico con la más actualizada información